Proof of Concept auf der CeBIT

Zahlreiche Experten, die sich für die technologische Revolution, die sich vor unseren Augen abspielt, interessieren, überholen sich gegenseitig in den Statistiken bezüglich der Menge der Daten, die die Menschheit in den kommenden Jahren erzeugen wird. Die Verarbeitung großer Informationsressourcen wird in diesem Zusammenhang zu einer riesigen Herausforderung.

Zu den Problemen, die während den Operationen auf dem sog. Big Data ausführt werden, gehören:

- Verhinderung der Aufzeichnung der Informationen zu den klassischen relationalen Datenbanken sowie Durchführung von Analysen, die zu wichtigen Geschäftsinformationen führen, verursacht durch ihre unstrukturierte Form

- Notwendigkeit, Datenströme „live” zu verarbeiten, womit die bisherigen Business-Intelligence-Lösungen nicht klar kommen

- Speicherung von einer Vielzahl von Quellen und Datenmengen in den Data-Warehouse-Lösungen wird zu teuer und ineffizient

Wichtige Quelle, aus der Informationen gewonnen werden können (zum Beispiel in Bezug auf Meinungen über Produkte und aktuelle Trends), die einen hohen Wert für Marketingabteilungen haben, sind die sozialen Netzwerke. Eine natürliche Sprache (vor allem ihre umgangssprachliche Form), die am häufigsten auf solchen Plattformen wie Twitter und Facebook zu finden ist, erweist sich als problematisch bei der Analyse. Dennoch, was die Bedeutung von Inhalten und den steigenden Bedarf an Strukturierung von Informationen betrifft, ist im Moment die Verarbeitung solcher Daten eine der Big-Data- Zweige, die am schnellsten wächst.

Bei Apollogic verfolgen wir ständig den Markt, um die besten Lösungen zu finden, die in zukünftigen Projekten verwendet werden können. Daher führten wir während der diesjährigen Auflage der Messe CeBIT in Hannover einen PoC (Proof of Concept), der entwickelt wurde, um die neuesten Big-Data-Technologien zu testen, die eine effiziente Verarbeitung von unstrukturierten Daten ermöglichen.

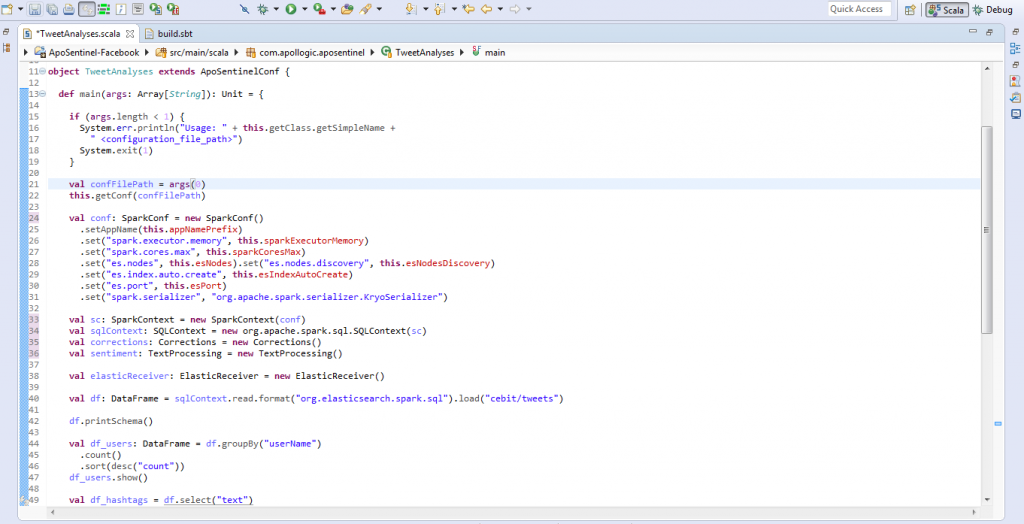

Das Ziel des Projekts war es, Tweets zu analysieren, die im Netz während der größten Technologiemesse der Welt erscheinen. Die Analyse hatte die Frage zu beantworten, welche Tools und Trends in der IT am häufigsten diskutiert werden. Außerdem sollte sie auch die Meinungen beurteilen.

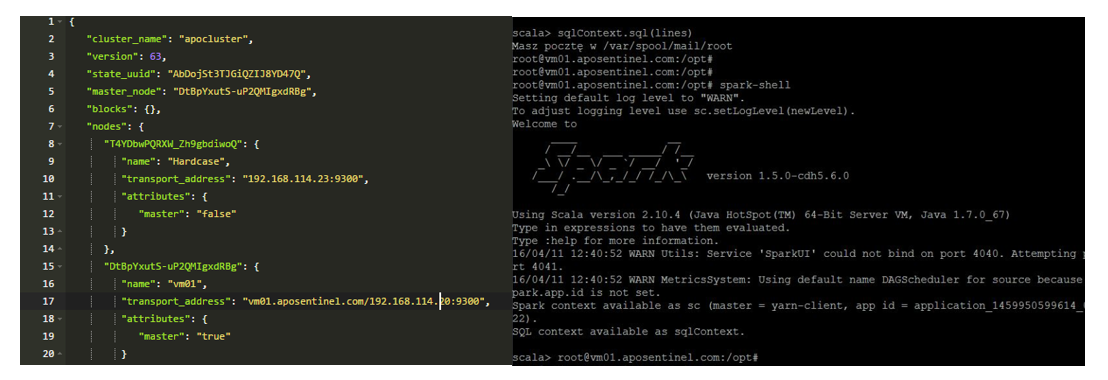

Während der Veranstaltung wurden fast 50.000 Beiträge auf Twitter im Zusammenhang mit dem Event veröffentlicht. Zur Durchführung aller notwendigen Operationen wurde ein Cluster von Computern entwickelt, auf dem eine Umgebung installiert wurde, die aus folgenden Werkzeugen bestand:

- Apache Spark

- Apache Hadoop

- Elasticsearch

Diese Kombination ermöglicht eine hohe Leistung und einen großen Komfort bei der Datenverarbeitung.

Bemerkenswert sind vor allem Bibliotheken, die durch das Werkzeug Apache Spark angeboten werden. Die Nutzung von Spark-Streaming ermöglicht eine einfache Ausführung von teuren Operationen für den Computer-Speicher auf dem Datenstrom. Die Darstellung des Datensatzes, die in Apache Spark eine Zerstreuung über eine Vielzahl von Maschinen ermöglicht, wird RDD (Resilient Distributed Dataset) genannt. Die folgende Abbildung verdeutlicht eine grafische Darstellung der Architektur des Spark-Streaming-Datenstroms:

Eine sehr nützliche Option ist auch eine DataFrames-Bibliothek. Es ist eine Sammlung von Daten, die auf Basis von verschiedenen Quellen erzeugt werden kann, z. B. JSON in Form von Spalten. Auf diese Weise können Sie die klassischen SQL-Abfragen ausführen. Dies beschleunigt erheblich und erleichtert die Arbeit an den Daten, sowie verbessert ihre Verbindung aus verschiedenen Quellen.

Dank so einem ausgewählten Satz von Tools konnte man das Projekt schnell und effizient durchführen. Allerdings lässt die Verarbeitung natürlicher Sprache noch eine Menge Möglichkeiten offen, die im Laufe der Zeit und mit dem Erscheinen auf dem Markt immer besserer Lösungen sicherlich verwendet werden.

- On 15/04/2016

0 Comments